Profilorientierte Kennzahlen und Rankings: Die "beste Universität" gibt es nicht

Prof. Dr. Frank Ziegele, Geschäftsführer CHE gemeinnütziges Centrum für Hochschulentwicklung

Foto: CHE – Centrum für Hochschulentwicklung

Wie misst man die Leistungen von Hochschulen? Und: Was sollen die Hochschulen mit den Messungen tun?

Internationale Rankings, die wie Bundesligatabellen funktionieren, bieten scheinbar einfache Lösungen für eine Leistungsmessung, um Beispiel "Wir sind die Nummer fünf in Deutschland". Aber was sagt uns das eigentlich? Erst mal gar nichts, denn Leistungsmessung ist so gut wie die Passung zwischen dem Betrachtungsgegenstand – den Hochschulen mit ihren vielfältigen Profilen – und dem Messinstrument.

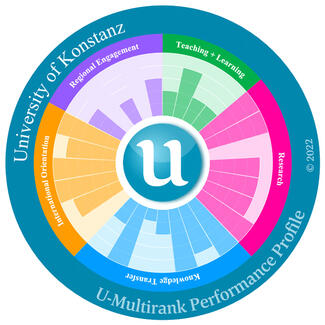

Im Klartext heißt das: Die Aufgaben der Hochschulen sind mehrdimensional, also muss auch die Leistungsmessung mehrdimensional sein. Messsysteme wie die genannten Rankings haben jedoch derzeit vor allem einen eindimensionalen Fokus auf Publikationen und Drittmittel. Diese stark forschungsorientierten Leistungsindikatoren sind wiederum entscheidend für die Reputation von Hochschulen, ein weiterer Faktor der globalen Rankings. Vielfältige Profile, zum Beispiel von Hochschulen für Angewandte Wissenschaften (HAWs), werden aber nur greifbar mit einer Vielfalt an Indikatoren, die auch die anderen Missionen der Hochschulen neben der Forschung aufgreifen. Das heißt, Hochschulen müssen eigene, profilgerechte Messansätze finden und kommunizieren, anstatt sich auf einem bestimmten Rankingplatz zu wähnen. Die Leistungsbewertung muss für jede Hochschule zu ihrem Profil und ihren Zielen passen. Ein Beispiel für einen multidimensionalen Messansatz ist das unabhängige U-Multirank, das maßgeblich durch die EU-Kommission gefördert wird. Das multidimensionale, flexible Tool ermöglicht die hochschulprofilspezifische Abbildung von Stärken und Schwächen einer Hochschule.

Dazu zwei Beispiele. Jeder der Balken in den dargestellten Leistungsprofilen entspricht einem Indikator, der längste Balken entspricht der Topgruppe im weltweiten Vergleich. Die Analyse der Topgruppen zeigt für die Hochschule Niederrhein: sie ist erfolgreich mit der regionalen Wirtschaft vernetzt (co-publications with industrial partners, regional joint publication) und arbeitet stark interdisziplinär (interdisciplinary publications). Grundlagenforschung und internationale Mobilität sind weniger ausgeprägt an dieser Hochschule.

Die Universität Konstanz hingegen ist insbesondere international leistungsstark (student mobility, international academic staff, international joint publications) sowie wirtschaftlich vernetzt (co-publications with industrial partners), forschungs- und patentstark (research publications, external research income, patents awarded, publications cited in patents) und besonders attraktiv für Post-docs. Regionales ist für diese Hochschule hingegen von geringer Bedeutung.

Eine multidimensionale Betrachtung hilft den Hochschulen nicht nur Stärken und Schwächen zu identifizieren, sondern auch zu reflektieren, ob sie dort stark sind, wo sie es sein wollen. Auf dieser Basis können Hochschulen entscheiden, wie sie auf Differenzen zwischen Ziel, Selbstbild und Performance reagieren.

Klassische "League table"-Rankings richten hingegen in einem solchen Prozess nur Schaden an. Liga-Tabellen sind beschränkt durch Einseitigkeit in der Messung und Vermischung horizontaler und vertikaler Unterschiede ("anders" vs. "besser"). So misst etwa das Shanghai Ranking lediglich Forschung, was jedoch hinter einer intransparenten Gesamtbewertung (Platzierung) versteckt wird. Hier werden Hochschulen eindimensional als gut oder weniger gut eingestuft. Dabei wird übersehen: Die "beste Universität" gibt es nicht. Profilvielfalt erfordert erstens differenzierte Indikatoren und erlaubt zweitens nur einen Leistungsvergleich zwischen Hochschulen mit ähnlichen Profilen. Es gibt also nur die beste Hochschule in Bezug auf einzelne Indikatoren, eine Aggregation ergibt keinen Sinn.

Einseitige Messansätze bergen enorme Gefahren: Sie beruhen auf einem auf Forschung verengten Exzellenzbegriff, der diverse Hochschulprofile nur eingeschränkt abbilden kann. Das hat Folgen. So werden verzerrte Entscheidungen getroffen wie überzogenes Publizieren statt eines Einsatzes für die Wissenschaftskommunikation, denn letztere wird in Rankings nicht belohnt. Teilweise lassen Regierungen im Ausland nur Studierendenaustausch mit Universitäten zu, die Topplatzierungen in Ligatabellen haben. Das führt zu einer ineffizienten Chancenungleichheit bei der internationalen Mobilität zu Lasten beispielsweise von HAWs. Und dann sind da noch die Studierenden, die durch verengte Liga-Tabellen in die Irre geführt werden und sich für die vermeintlich beste Hochschule entscheiden. Dabei landen sie leicht an einer Hochschule, die gar nicht zu ihren Bedürfnissen und Interessen passt, oder die sich angesichts eines starken Forschungsfokus möglicherweise zu wenig für die Lehre engagiert.

Damit ist klar: Leistungsmessung darf nicht als Ausrichtung auf die oberen Tabellenplätze globaler Hochschulrankings begriffen werden. Die "Key Performance Indikators" (KPIs) jeder Hochschule sind unterschiedlich und profilspezifisch auszuwählen. Für Hochschulräte heißt das: Achten Sie auf Ausgewogenheit der hochschulischen Kernaufgaben in der Leistungsmessung. Diskutieren Sie mit der Hochschule, welche Messansätze zu ihrem Profil passen. Unterstützen Sie Anstrengungen der Hochschule profilbezogene Leistungstransparenz herzustellen. Und lassen Sie bitte die Hochschule mit der Frage "Auf welchem Platz stehen wir in Deutschland, Europa oder in der der Welt?" in Ruhe. Ermuntern Sie stattdessen zum Benchmarking mit vergleichbaren Referenz-Hochschulen, um daraus für evidenzbasierte strategische Entscheidungen zu lernen. Und vergessen Sie dabei nicht: Die KPIs einer Hochschule bilden ein Phänomen ab, sie sind nicht das Phänomen selbst. Es gibt immer Spielräume in der Aussagekraft und Zahlen bedürfen am Ende immer einer sorgfältigen Interpretation.